(爱云资讯消息)在发布上一个大型AI模型仅两个月后,Meta又推出了一项重大更新:其首个能够处理图像和文本的开源模型。

新推出的模型Llama 3.2可以让开发者创建更为先进的AI应用,比如提供实时视频理解的增强现实应用程序;基于内容对图像进行分类的视觉搜索引擎;以及能够总结长篇文本的文档分析工具。

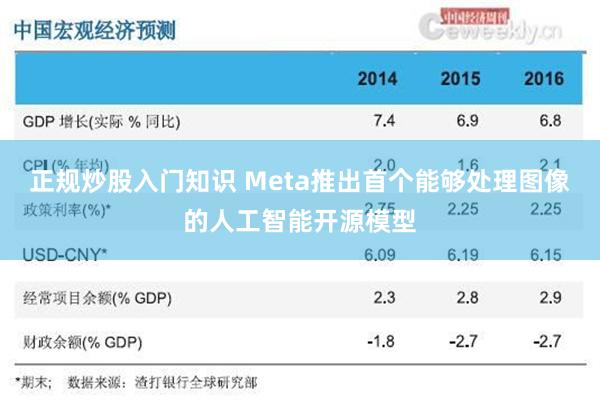

随着主要券商2023年年报陆续披露,这些券商旗下以股权投资为主的私募投资基金的子公司情况也显露出来。从体量来看,中金公司、中信证券等旗下私募股权明显领先,中金公司在管超4000亿元;从投资方向来看,各大券商纷纷表示响应国家战略,聚焦重点区域以及新质生产力方向;募资方面,各家券商私募子公司也积极瞄向政策型资金。

Meta表示,开发者将能够轻松地将新模型投入使用。Meta的生成式AI副总裁阿迈德·阿尔达勒(Ahmad Al-Dahle)在接受外媒采访时表示,开发者只需添加多模态功能,就能展示Llama图像并让其进行交流。

其他AI开发者,包括OpenAI和谷歌,去年已经推出了多模态模型,因此Meta在这里处于追赶地位。随着Meta继续在其Ray-Ban Meta眼镜等硬件上构建AI能力,视觉支持也将发挥关键作用。

Llama 3.2版本包含两个视觉模型(参数量为110亿和900亿)和两个轻量级纯文本模型(参数量为10亿和30亿)。较小的模型是为高通、联发科和其他Arm硬件设计的,Meta显然希望它们能在移动设备上得到应用。

不过正规炒股入门知识,稍微老一点的Llama 3.1版本仍有一席之地:这款模型于今年7月发布,其中包含一个拥有4050亿参数的版本,理论上在生成文本方面将具有更强的能力。

MetaLlama参数量模型开发者发布于:河北省文章为作者独立观点,不代表配资网上开户_配资证券开户_在线炒股配资门户观点

相关文章